让AI作画自己纠错! 随机丢模块就能提升生成质量, 告别塑料感废片

- 2025-08-23 16:19:49

- 986

AI作画、生视频,可以「自己救自己」了?!

当大家还在为CFG(无分类器引导)的参数搞到头秃,却依然得到一堆“塑料感”废片而发愁时,来自清华大学、阿里巴巴AMAP(高德地图)、中国科学院自动化研究所的研究团队,推出全新方法S²-Guidance(StochasticSelf-Guidance)。

核心亮点在于通过随机丢弃网络模块(StochasticBlock-Dropping)来动态构建“弱”的子网络,从而实现对生成过程的自我修正。这不仅让AI学会了“主动避坑”,更重要的是,它避免了其他类似方法中繁琐、针对特定模型的参数调整过程,真正做到了即插即用、效果显著。

S²-Guidance方法在文生图和文生视频任务中,显著提升了生成结果的质量与连贯性。

具体表现在:

一、CFG的瓶颈:效果失真+缺乏通用性

在扩散模型的世界里,CFG(Classifier-FreeGuidance)是提升生成质量和文本对齐度的标准操作。但它的“线性外推”本质,导致高引导强度下容易产生过饱和、失真等问题。

为了解决这个问题,学术界此前的思路是引入一个“监督员”——弱模型(weakmodel)。比如Autoguidance就提出用训练不充分的模型来修正。但这个思路在实践中遇到了核心难题:如何找到一个“恰到好处”的弱模型?

为了绕开这个难题,后续的一些工作尝试“凭空制造”弱模型。它们通过在推理时手动修改网络结构来实现,比如模糊化特定的注意力图(AttentionMap),或者在视频生成中跳过某些时空注意力层。但这些方法又带来了新的问题:它们通常是高度定制化的,需要针对不同任务进行精细的参数调整和大量的实验,缺乏通用性,使用起来非常繁琐。

S²-Guidance则另辟蹊径,它问了一个直击灵魂的问题:我们能不能不找外援,也不搞复杂的调参,让模型自己监督自己,并且这个过程是通用且自动的?

二、S²-Guidance的精妙构思:“随机丢模块”就够了

S²-Guidance在生成质量流形上的工作机制如下图所示。

生成过程从当前状态(Mₜ,橙色线框)向下一个状态(Mₜ₋₁)演进。标准CFG提供了一个强力但不够精准的引导方向(灰色箭头),它无法精确地命中代表最高质量的“山峰”(黄色峰值)。S²-Guidance的改进之处在于:它通过随机丢弃网络模块的策略,计算出一个“自我修正”的预测(蓝色箭头,“随机丢弃后的预测”)。最终,合成的S²-Guidance引导向量(紫色箭头)能更精准地将生成过程引向流形上的最优区域,最终得到保真度更高的结果。

第一步:通过随机模块丢弃,动态构建内生子网络

高性能扩散模型(如SD3)的核心架构多为Transformer,由一系列功能相似的Block堆叠而成。研究表明,这类大型网络存在显著的模型冗余(modelredundancy)。

S²-Guidance巧妙地利用了这一点。如图2所示,在每个推理步骤中,它通过随机模块丢弃(StochasticBlock-Dropping)这一策略,在前向传播时临时“跳过”或“屏蔽”掉一小部分网络模块。这个过程等效于在推理时动态地、无成本地构建出一个轻量化的内生子网络(intrinsicsub-network)。

这个子网络并非外部训练的“弱模型”,而是完整模型的一个原生变体。由于部分功能模块被临时禁用,其预测能力相对受限,而它的预测结果恰恰暴露了完整模型在高认知不确定性(epistemicuncertainty)区域的“潜在错误倾向”。这种方法的优越性在于,它是一种通用且自动的策略,无需研究者手动判断应修改哪个特定模块,也无需为不同任务设计不同的“手术方案”。

第二步:利用子网络预测进行负向引导

当子网络给出了其预测方向后,S²-Guidance执行了其最关键的一步:负向引导修正。它并非尝试去靠近或模仿子网络的预测,而是主动地排斥(repel)它。

这在S²-Guidance的引导公式中体现得淋漓尽致,其核心逻辑可以直观地理解为:

最终引导方向=标准CFG引导方向-子网络预测的“高不确定性”方向

通过这个简单的“纠错式减法”,模型在保持CFG强引导力的同时,被一个源自内部的修正信号“拉回”,从而精准地规避了那些可能导致生成低质量、不真实结果的“陷阱区域”。最终,该方法在无需外部模型和繁琐参数微调的前提下,实现了便捷、通用且高效的自我优化。

理论先行:在“玩具实验”中验证可行性

在提出这个大胆的假设后,研究团队首先在一维和二维的高斯混合分布(GaussianMixture)这种有精确解的“玩具实验”上进行了验证。结果(如下图-图3所示)非常清晰:

S²-Guidance实现了引导强度与分布保真度的平衡。在玩具实验中,CFG(红框)会扭曲分布,而S²-Guidance能精准地捕获真实数据分布(半透明区域)的位置和形状,缓解了模式分离和分布失真的问题。

有了理论上的坚实基础,团队才将其推广到更复杂的图像和视频生成任务中。

三、实验效果:全方位、可量化的质量提升

理论说得天花乱坠,不如看疗效。S²-Guidance在各大SOTA模型上,展现出了令人信服的、全方位的实力提升。

1全面的视觉质量提升

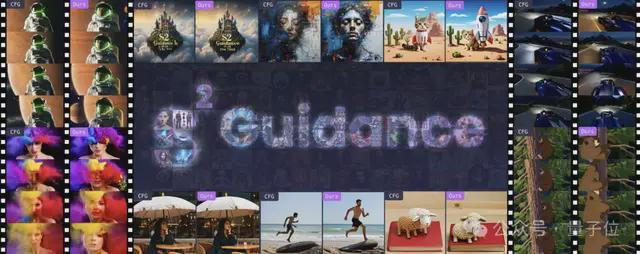

开篇的这张对比图(图1)就是最好的证明。简单来说,S²-Guidance让生成结果在多个维度上实现了飞跃:

S²-Guidance在美学质量和指令遵循度上,总能生成更出色的图像。可以看到,像CFG、APG、CFG++和CFG-Zero这些现有的引导方法,常常会生成各种瑕疵,比如不自然的伪影、变形的物体,或者干脆无法理解复杂的指令(见红框)。而S²-Guidance方法则能产出干净、协调、观感舒适的图像,完美地规避了这些问题。

2同台竞技,更胜一筹

当和其他先进的引导方法(如APG、CFG++、CFG-Zero)同台竞技时,S²-Guidance的优势就体现在稳定性上。在图4中可以看到,对于复杂的prompt,其他方法(红色框内)往往会产生扭曲的物体或不自然的伪影,或者干脆无法遵循完整的指令。而S²-Guidance则能稳定地生成干净、连贯且高度符合prompt描述的图像,在美学质量(aestheticquality)和指令遵循度(promptcoherence)上都表现出色。

图5.S²-Guidance能够生成时间和物理上都更合理的视频,解决了CFG的两大核心问题。顶行对比:CFG无法生成合理的运动,它让卡车诡异地“横向漂移”而不是向前开(见红框)。相比之下,S²-Guidance渲染出了一个稳定又真实的行车场景。底行对比:CFG没有完全理解指令,生成的光线并未“环绕”人脸(红色框),并且也漏掉了“发光粒子”这一细节(蓝色框)。而S²-Guidance则忠实地还原了整个prompt,生成了一个动态感十足、视觉元素丰富的场景。

3视频生成:告别“指令遗忘症”,拥抱物理真实感

在视频生成中,S²-Guidance更是解决了CFG的两个核心痛点:

4硬核数据:领先的性能表现

这些视觉提升的背后,是HPSv2.1、T2I-CompBench、VBench等权威榜单上实打实的领先成绩。例如,在SD3模型和T2I-CompBench基准上,S²-Guidance在颜色、形状、纹理等维度的得分上均超越了包括CFG-Zero在内的所有对比方法。在VBench视频评测中,S²-Guidance同样在总分、语义一致性等多个关键指标上取得了最优性能。

HPSv2.1、T2I-CompBench榜单上的对比

图7:VBench榜单上的对比图7:VBench榜单上的对比

视觉效果对比

S²-Guidance:

Baseline:

四、不只是有效,而且高效

搞这么一套“自我纠错”系统,会不会很慢?答案是几乎不慢。

研究者在论文中通过严谨的消融实验证明,哪怕在每个去噪步骤中只分裂出一个“小号”(即N=1),效果也和分裂出几十个小号取平均(NaiveS²-Guidance)几乎一样好。

这得益于扩散过程单一步的微小随机抖动,在几十上百步的迭代中会被自然地“平均”掉,最终共同将生成结果稳稳地导向高质量的终点。

一句话总结:S²-Guidance用较小的计算代价,实现了显著的质量提升。

- 上一篇:再次验证了世界是一个巨大的草台班子

- 下一篇:人体最脏的部位